ベクター (svg) 画像も扱えて、タブレットにも対応した、無料・オープンソースのペイントソフト Krita で、 AI を用いて画像を生成するプラグイン「krita-ai-diffusion」でローカルマネージドサーバにインストールできる項目の意味やライセンスを確認しながら数話に分けて紹介します。

※ CreativeML Open RAIL-M/M++ ライセンスについては、「CreativeML OpenRAIL M と M++ のライセンスの解釈」を参照してください。

※ライセンスについては使用するもの以外は基本的に記載しません。また、記載しているライセンスの意味は、調べた筆者の解釈なので詳細はライセンス自体をお読みください。

※ Krita のバージョンは 5.2.9 です。

※ krita-ai-diffusion のバージョンは 1.34.0 です。

- 前回の記事

- 各モデルデータのダウンロード元について

- krita-ai-diffusion ローカルサーバの設置 (Part5)

- Illustrious/NoobAI XL models の任意の選択

- NoobAi XL (Illustrious -Anime)

- ControlNet Scribble (Illustrious)

- ControlNet Line Art (Illustrious)

- ControlNet Soft Edge (Illustrious)

- ControlNet Canny (Illustrious)

- ControlNet Depth (Illustrious)

- ControlNet Normal (Illustrious)

- ControlNet Pose (Illustrious)

- ControlNet Unblur (Illustrious)

- CLIP Vision G (for IP-Adapter)

- IP-Addapter (Illustrious)

- Illustrious/NoobAI XL models の任意の選択

- まとめ

- 参照サイト Thank You!

前回の記事

前回の Part4 の記事は以下です。

各モデルデータのダウンロード元について

紹介する拡散ベースモデル (Workloads) 、拡散モデル (CheckPoint) 、拡張機能 (ControlNet) の各モデルデータを krita-ai-diffusion がダウンロードする場所については以下の記事を参照してください。

krita-ai-diffusion ローカルサーバの設置 (Part5)

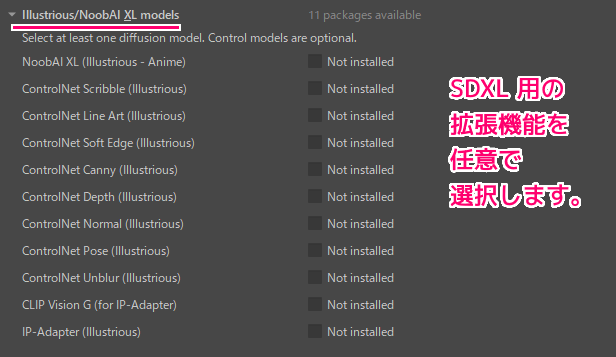

Illustrious/NoobAI XL models の任意の選択

Illustrious/NoobAI XL models セクションでインストールを選択できる項目について、インストールするファイルのリンク先をもとに内容を確認します。

NoobAi XL (Illustrious -Anime)

「Base Models | Krita AI Handbook」によると、インストール先は「NoobAI-XL (NAI-XL) – V-Pred-1.0-Version | NoobAI Checkpoint | Civitai」にあります。

アニメに特化したモデルです。

A line of anime-focused models. They are based on the SDXL architecture but have been trained on a different dataset. This makes them largely incompatible with extensions and LoRA from “regular” SDXL models. Instead they are supported by their own set of extensions.

アニメに特化したモデルをラインナップ。これらは SDXL アーキテクチャに基づいていますが、別のデータセットでトレーニングされています。これにより、「通常の」SDXL モデルの拡張機能や LoRA との互換性がほとんどなくなります。代わりに、それらは独自の拡張機能のセットによってサポートされます。NoobAI-XL (NAI-XL) – V-Pred-1.0-Version | NoobAI Checkpoint | Civitai と Google 翻訳

商用利用は禁止、クレジット表記の義務あり

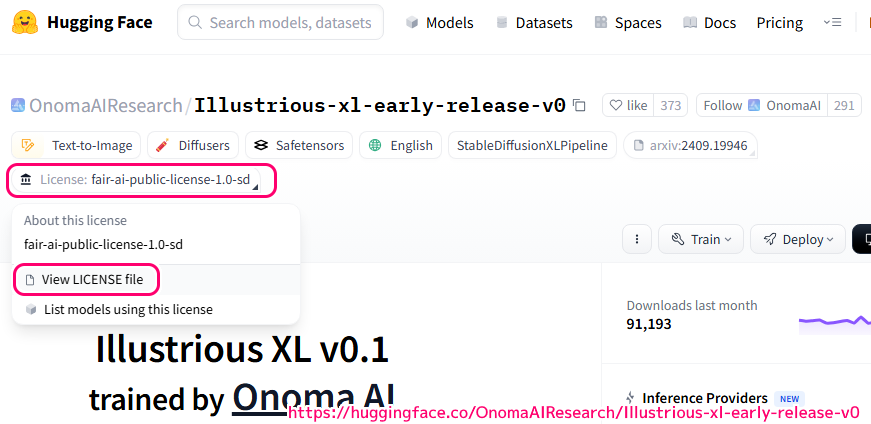

引用に書かれている URL のページ(OnomaAIResearch/Illustrious-xl-early-release-v0 · Hugging Face)の Lisense: fair-ai-public-license-1.0-sd タグを開くと、「Freedom of Development」が開かれました。

This model’s license inherits from https://huggingface.co/OnomaAIResearch/Illustrious-xl-early-release-v0 fair-ai-public-license-1.0-sd and adds the following terms. Any use of this model and its variants is bound by this license.

モデルライセンス このモデルのライセンスは、https://huggingface.co/OnomaAIResearch/Illustrious-xl-early-release-v0 Fair-ai-public-license-1.0-sd を継承し、次の条件を追加します。このモデルとそのバリアントの使用はすべて、このライセンスに拘束されます。

README.md · Laxhar/noobai-XL-1.0 at main と Google 翻訳

開かれたページに書かれている Fair-AI-Public-License-1.0-SD ライセンスは、商用利用が禁止されています。

【#2】イラスト向けStable Diffusionと派生モデル、Fair-AI-Public-License-1.0-SD解説【ComfyUI講座】【2025年版】|kazumu

- ライセンス名 Fair-AI-Public-License-1.0-SD

- 対象 :Stable Diffusion系モデル(例:NoobAI, Illustrious など)

- 商用利用: ❌ 禁止(個人・企業を問わず)

- 非商用利用: ✅ 許可(研究、趣味、教育目的など)

- 改変・ファーク(派生): ✅ 許可(ただし同ライセンスの下で公開が必要)

- 再配布: ✅ 許可(オリジナルと同じライセンスを明示)

- 著作権表示の義務: ✅ 必須(クレジットやライセンス表記を含めること)

- 禁止事項: 不正利用、差別的・有害な用途、AI差別訓練データの抽出

- 商用API化 :❌ 禁止(APIや有料サービスへの組み込みも不可)

- 収益化支援(例:Patreon): ⭕ 条件付き可(明確にモデルそのものの販売でなければOKとされる場合あり)

- 使用例: 個人作品、非営利の同人活動、教育用ツールの作成など

また、「README.md · Laxhar/noobai-XL-1.0 at main」によると、以下の追加の条件を守る必要があります。

I. Usage Restrictions

- Prohibited use for harmful, malicious, or illegal activities, including but not limited to harassment, threats, and spreading misinformation.

- Prohibited generation of unethical or offensive content.

- Prohibited violation of laws and regulations in the user’s jurisdiction.

We prohibit any form of commercialization, including but not limited to monetization or commercial use of the model, derivative models, or model-generated products.

To foster a thriving open-source community,users MUST comply with the following requirements:

- Open source derivative models, merged models, LoRAs, and products based on the above models.

- Share work details such as synthesis formulas, prompts, and workflows.

- Follow the fair-ai-public-license to ensure derivative works remain open source.

Generated models may produce unexpected or harmful outputs. Users must assume all risks and potential consequences of usage.

I. 利用制限 嫌がらせ、脅迫、誤った情報の拡散などを含むがこれらに限定されない、有害、悪意のある、または違法な活動への使用は禁止されています。 非倫理的または攻撃的なコンテンツの生成を禁止します。 ユーザーの管轄区域内の法令に違反する行為を禁止します。 II.商業禁止 当社は、モデル、派生モデル、またはモデルで生成された製品の収益化や商業利用を含むがこれらに限定されない、いかなる形態の商業化も禁止します。 Ⅲ.オープンソース コミュニティ オープンソース コミュニティの繁栄を促進するには、ユーザーは次の要件に従わなければなりません。 オープンソースの派生モデル、結合モデル、LoRA、および上記のモデルに基づく製品。 合成式、プロンプト、ワークフローなどの作業の詳細を共有します。 Fair-AI-Public-License に従い、派生作品がオープンソースのままであることを保証します。 IV.免責事項 生成されたモデルは、予期しない出力または有害な出力を生成する可能性があります。ユーザーは、使用によるすべてのリスクと潜在的な結果を引き受ける必要があります。README.md · Laxhar/noobai-XL-1.0 at main と Google 翻訳

ControlNet Scribble (Illustrious)

「Eugeoter/noob-sdxl-controlnet-scribble_pidinet · Hugging Face」には説明が一切ないため不明です。

part3 で SD1.5 版の Scribble を調べた際には、スクリブルで安定した拡散を制御する機能でした。

Control Stable Diffusion with Scribbles.

スクリブルで安定した拡散を制御します。

lllyasviel/ControlNet-v1-1-nightly: Nightly release of ControlNet 1.1 と Google 翻訳

ControlNet Line Art (Illustrious)

「Eugeoter/noob-sdxl-controlnet-lineart_anime · Hugging Face」には説明が一切ないため不明です。

part3 で SD1.5 版の Line Art を調べた際には、画像から線画を生成する機能でした。

This model is trained on awacke1/Image-to-Line-Drawings. The preprocessor can generate detailed or coarse linearts from images (Lineart and Lineart_Coarse). The model is trained with sufficient data augmentation and can receive manually drawn linearts.

このモデルは、awacke1/Image-to-Line-Drawings でトレーニングされています。プリプロセッサは、画像から詳細または粗い線画を生成できます (Lineart および Lineart_Coarse)。モデルは十分なデータ拡張を使用してトレーニングされており、手動で描画された線画を受け取ることができます。lllyasviel/ControlNet-v1-1-nightly: Nightly release of ControlNet 1.1 と Google 翻訳

ControlNet Soft Edge (Illustrious)

「Eugeoter/noob-sdxl-controlnet-softedge_hed · Hugging Face」には説明が一切ないため不明です。

part3 で SD1.5 版の Soft Edge を調べた際には、ソフトエッジで安定した拡散を制御する機能でした。

Control Stable Diffusion with Soft Edges.

ソフトエッジで安定した拡散をコントロール。lllyasviel/ControlNet-v1-1-nightly: Nightly release of ControlNet 1.1 と Google 翻訳

ControlNet Canny (Illustrious)

「Eugeoter/noob-sdxl-controlnet-canny · Hugging Face」には説明が一切ないため不明です。

part3 で SD1.5 版の Canny を調べた際には、Canny Maps (鋭いエッジ)で安定した拡散を制御する機能でした。

Control Stable Diffusion with Canny Maps.

Canny Maps で安定した拡散を制御します。lllyasviel/ControlNet-v1-1-nightly: Nightly release of ControlNet 1.1 と Google 翻訳

ControlNet Depth (Illustrious)

「Eugeoter/noob-sdxl-controlnet-depth_midas-v1-1 · Hugging Face」には説明が一切ないため不明です。

part3 で SD1.5 版の Depth を調べた際には、複数の解像度で複数の深度マップを生成する機能でした。

Training data: Midas depth (resolution 256/384/512) + Leres Depth (resolution 256/384/512) + Zoe Depth (resolution 256/384/512). Multiple depth map generator at multiple resolution as data augmentation.

Acceptable Preprocessors: Depth_Midas, Depth_Leres, Depth_Zoe. This model is highly robust and can work on real depth map from rendering engines.

トレーニング データ: ミダスの深度 (解像度 256/384/512) + レレスの深度 (解像度 256/384/512) + ゾーイの深度 (解像度 256/384/512)。データ拡張として複数の解像度で複数の深度マップを生成します。 使用可能なプリプロセッサ: Depth_Midas、Depth_Leres、Depth_Zoe。このモデルは非常に堅牢であり、レンダリング エンジンからの実際の深度マップで動作できます。lllyasviel/ControlNet-v1-1-nightly: Nightly release of ControlNet 1.1 と Google 翻訳

ControlNet Normal (Illustrious)

「Eugeoter/noob-sdxl-controlnet-normal · Hugging Face」には説明が一切ないため不明です。

part3 で SD1.5 版の Normal を調べた際には、ノーマルマップ(法線マップ)を扱う機能でした。

Normal BAE. This model can accept normal maps from rendering engines as long as the normal map follows ScanNet’s protocol. That is to say, the color of your normal map should look like the second column of this image.

通常のBAE。このモデルは、法線マップが ScanNet のプロトコルに従っている限り、レンダリング エンジンからの法線マップを受け入れることができます。つまり、法線マップの色は、この画像の 2 番目の列のようになります。lllyasviel/ControlNet-v1-1-nightly: Nightly release of ControlNet 1.1 と Google 翻訳

ControlNet Pose (Illustrious)

「Laxhar/noob_openpose · Hugging Face」には説明が一切ないため不明です。

part3 で SD1.5 版の Scribble を調べた際には、OpenPose により元画像や棒人間からポーズを抽出して、同じポーズの画像を生成する機能でした。

The model is trained and can accept the following combinations:

lllyasviel/ControlNet-v1-1-nightly: Nightly release of ControlNet 1.1 と Google 翻訳

- Openpose body

- Openpose hand

- Openpose face

- Openpose body + Openpose hand

- Openpose body + Openpose face

- Openpose hand + Openpose face

- Openpose body + Openpose hand + Openpose face

ControlNetはStable Diffusionの拡張機能の一つであり、その機能はContorlNetのモデルによって異なります。

ControlNet OpenPosedでは、元画像や棒人間からポーズを抽出して、同じポーズの画像を生成することができます。

【Stable Diffusion Web UI】ControlNetの使い方 OpenPose | 業界最安級GPUクラウド | GPUSOROBAN

ControlNet Unblur (Illustrious)

「Eugeoter/noob-sdxl-controlnet-tile · Hugging Face」には説明(謝辞を除く)が一切ないため不明です。

以下の引用元によると、解像度の低い画像を高画質化します。

「Unblur」は、ぼやけた画像を鮮明にするコントロールレイヤーで、解像度の低い画像を高画質化する際に便利です。

イラスト作成のためのKrita AI Diffusionの全コントロールレイヤー完全ガイド|鷹の目週末プログラマー

下の例では、拡大してぼやけた画像をUblurにより高解像度に変換しています。

CLIP Vision G (for IP-Adapter)

テキストから画像への拡散モデルの画像プロンプト機能を実現する効果的で軽量なアダプターです。

※ Part 3 の SD1.5 の IP-Adapter と同じリンク先でした。

we present IP-Adapter, an effective and lightweight adapter to achieve image prompt capability for the pre-trained text-to-image diffusion models. An IP-Adapter with only 22M parameters can achieve comparable or even better performance to a fine-tuned image prompt model. IP-Adapter can be generalized not only to other custom models fine-tuned from the same base model, but also to controllable generation using existing controllable tools. Moreover, the image prompt can also work well with the text prompt to accomplish multimodal image generation.

事前トレーニングされたテキストから画像への拡散モデルの画像プロンプト機能を実現する効果的で軽量なアダプターである IP アダプターを紹介します。わずか 2,200 万のパラメータを持つ IP アダプターは、微調整されたイメージ プロンプト モデルと同等またはそれ以上のパフォーマンスを達成できます。 IP アダプターは、同じベース モデルから微調整された他のカスタム モデルだけでなく、既存の制御可能なツールを使用した制御可能な生成にも一般化できます。さらに、画像プロンプトはテキスト プロンプトと連携して、マルチモーダルな画像生成を実現することもできます。h94/IP-Adapter · Hugging Face

IP-Addapter (Illustrious)

「r3gm/noob-ipa · Hugging Face」には説明が一切ないため不明です。

1つ前に紹介した CLIP Vision G (for IP-Adapter) と名前が似ているため関連があるかもしれません。

まとめ

5話にわけて、ベクター (svg) 画像も扱えて、タブレットにも対応した、無料・オープンソースのペイントソフト Krita で、 AI を用いて画像を生成するプラグイン「krita-ai-diffusion」でローカルマネージドサーバにインストールできる項目の意味やライセンスを確認しながら紹介しました。

参照サイト Thank You!

- Krita | デジタルでのお絵描きと創造の自由を

- Acly/krita-ai-diffusion: Streamlined interface for generating images with AI in Krita. Inpaint and outpaint with optional text prompt, no tweaking required.

- イラスト作成のためのKrita AI Diffusionの全コントロールレイヤー完全ガイド|鷹の目週末プログラマー

- Interstice

- Plugin Installation | Krita AI Handbook

- stable-diffusion-v1-5/stable-diffusion-v1-5 · Hugging Face

- lllyasviel/ControlNet · Hugging Face

- KritaのAI生成プラグイン「Krita AI Diffusion」をカスタムComfyUIサーバで試す

- CUDA – Wikipedia

- DirectML – Wikipedia

- Stable Diffusionのライセンス(利用規約)の確認方法を解説! | るんるんスケッチ

- モデルのライセンス「CreativeML Open RAIL-M」を読む – 画像生成ドットコム

- CreativeML Open RAIL-M ライセンス 全文和訳(非公式)

- Stable Diffusionの主な生成モデルとライセンス一覧 60+選【CIVITAI版】|Sasakisan

- 【画像生成AI】Stable Diffusion派生モデルを利用・公開するときはライセンスに注意しましょう|はせ@AI Photo

- OpenPoseなどのControlNetは商用利用できる?ライセンス・商用利用可能な機能について徹底解説! | romptn Magazine

- NOOBAI-XL FULL OFFICIAL GUIDE [TRANSLATED] | Civitai

- Laxhar/noobai-XL-1.0 · Hugging Face

- 【#2】イラスト向けStable Diffusionと派生モデル、Fair-AI-Public-License-1.0-SD解説【ComfyUI講座】【2025年版】|kazumu

記事一覧 → Compota-Soft-Press

コメント